Product

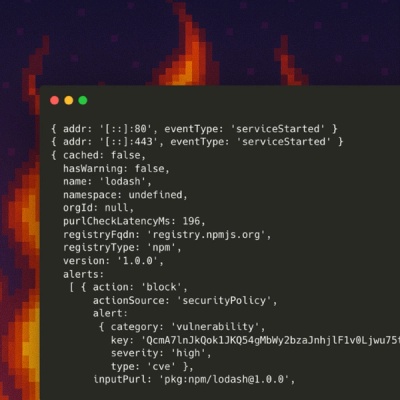

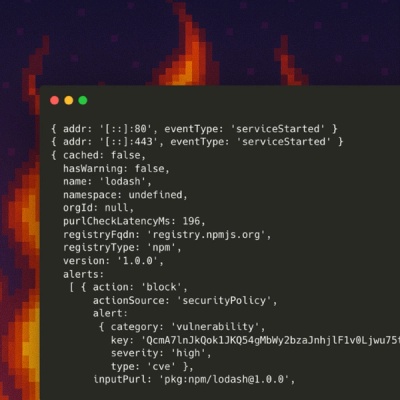

Introducing Socket Firewall Enterprise: Flexible, Configurable Protection for Modern Package Ecosystems

Socket Firewall Enterprise is now available with flexible deployment, configurable policies, and expanded language support.

pydatajson

Advanced tools

Paquete en python con herramientas para generar y validar metadatos de catálogos de datos en formato data.json.

Paquete en python con herramientas para manipular y validar metadatos de catálogos de datos.

Este README cubre los casos de uso más comunes para la librería, junto con ejemplos de código, pero sin mayores explicaciones. Para una versión más detallada de los comportamientos, revise la documentación oficial o el Manual de Uso de la librería.

$ pip install pydatajson

$ pip install -e .

A partir de la versión 0.2.x (Febrero 2017), la funcionalidad del paquete se mantendrá fundamentalmente estable hasta futuro aviso. De todas maneras, si piensa utilizar esta librería en producción, le sugerimos fijar la versión que emplea en un archivo requirements.txt.

La librería cuenta con funciones para cuatro objetivos principales:

A continuación se proveen ejemplos de cada uno de estas acciones. Si desea analizar un flujo de trabajo más completo, refiérase a los Jupyter Notebook de samples/

DataJson utiliza un esquema default que cumple con el perfil de metadatos recomendado en la Guía para el uso y la publicación de metadatos (v0.1) del Paquete de Apertura de Datos.

from pydatajson import DataJson

dj = DataJson()

Si se desea utilizar un esquema alternativo, por favor, consulte la sección "Uso > Setup" del manual oficial, o la documentación oficial.

is_valid_catalog(catalog).validate_catalog(catalog).Por conveniencia, la carpeta tests/samples/ contiene varios ejemplos de data.json bien y mal formados con distintos tipos de errores.

from pydatajson import DataJson

dj = DataJson()

catalog = "tests/samples/full_data.json"

validation_result = dj.is_valid_catalog(catalog)

validation_report = dj.validate_catalog(catalog)

print validation_result

True

print validation_report

{

"status": "OK",

"error": {

"catalog": {

"status": "OK",

"errors": [],

"title": "Datos Argentina"

},

"dataset": [

{

"status": "OK",

"errors": [],

"title": "Sistema de contrataciones electrónicas"

}

]

}

}

pydatajson puede interpretar catálogos en formatos:

Los catálogos pueden estar almacenados localmente o remotamente a través de URLs de descarga directa. También es capaz de interpretar diccionarios de Python con metadatos de catálogos.

from pydatajson import DataJson

dj = DataJson()

catalogs = [

"tests/samples/full_data.json", # archivo JSON local

"http://181.209.63.71/data.json", # archivo JSON remoto

"tests/samples/catalogo_justicia.xlsx", # archivo XLSX local

"https://raw.githubusercontent.com/datosgobar/pydatajson/master/tests/samples/catalogo_justicia.xlsx", # archivo XLSX remoto

{

"title": "Catálogo del Portal Nacional",

"description" "Datasets abiertos para el ciudadano."

"dataset": [...],

(...)

} # diccionario de Python

]

for catalog in catalogs:

validation_result = dj.is_valid_catalog(catalog)

validation_report = dj.validate_catalog(catalog)

Si ya se sabe que se desean cosechar todos los datasets [válidos] de uno o varios catálogos, se pueden utilizar directamente el método generate_harvester_config(), proveyendo harvest='all' o harvest='valid' respectivamente. Si se desea revisar manualmente la lista de datasets contenidos, se puede invocar primero generate_datasets_report(), editar el reporte generado y luego proveérselo a generate_harvester_config(), junto con la opción harvest='report'.

catalogs = ["tests/samples/full_data.json", "http://181.209.63.71/data.json"]

report_path = "path/to/report.xlsx"

dj.generate_datasets_report(

catalogs=catalogs,

harvest='none', # El reporte tendrá `harvest==0` para todos los datasets

export_path=report_path

)

# A continuación, se debe editar el archivo de Excel 'path/to/report.xlsx',

# cambiando a '1' el campo 'harvest' en los datasets que se quieran cosechar.

config_path = 'path/to/config.csv'

dj.generate_harvester_config(

harvest='report',

report=report_path,

export_path=config_path

)

El archivo config_path puede ser provisto a Harvester para federar los datasets elegidos al editar el reporte intermedio report_path.

Por omisión, en la salida de generate_harvester_config la frecuencia de actualización deseada para cada dataset será "R/P1D", para intentar cosecharlos diariamente. De preferir otra frecuencia (siempre y cuando sea válida según ISO 8601), se la puede especificar a través del parámetro opcional frequency. Si especifica expĺicitamente frequency=None, se conservarán las frecuencias de actualización indicadas en el campo accrualPeriodicity de cada dataset.

Conservando las variables anteriores:

dj.generate_harvester_config(

catalogs=catalogs,

harvest='valid'

export_path='path/to/config.csv'

)

from pydatajson.readers import read_catalog

from pydatajson.writers import write_json

from pydatajson import DataJson

dj = DataJson()

catalogo_xlsx = "tests/samples/catalogo_justicia.xlsx"

catalogo = read_catalog(catalogo_xlsx)

write_json(obj=catalogo, path="tests/temp/catalogo_justicia.json")

pydatajson puede calcular indicadores sobre uno o más catálogos. Estos indicadores recopilan información de interés sobre los datasets de cada uno, tales como:

La función usada es generate_catalogs_indicators, que acepta los catálogos como parámetros. Devuelve dos valores:

catalogs = ["tests/samples/full_data.json", "http://181.209.63.71/data.json"]

indicators, network_indicators = dj.generate_catalogs_indicators(catalogs)

# Opcionalmente podemos pasar como segundo argumento un catálogo central,

# para poder calcular indicadores sobre la federación de los datasets en 'catalogs'

central_catalog = "http://datos.gob.ar/data.json"

indicators, network_indicators = dj.generate_catalogs_indicators(catalogs, central_catalog)

Los tests se corren con nose. Desde la raíz del repositorio:

Configuración inicial:

$ pip install -r requirements_dev.txt

$ mkdir tests/temp

Correr la suite de tests:

$ nosetests

pydatajson - Read the DocsEl validador de archivos data.json desarrollado es mayormente un envoltorio (wrapper) alrededor de la librería jsonschema, que implementa el vocabulario definido por JSONSchema.org para anotar y validar archivos JSON.

resources>_update()downloadURL en indicadores de red.downloadURL de las distribuciones.verify_ssl y requests_timeout a los métodos de federación.verify_ssl y requests_timeout a DataJson que controla el comportamiento de descarga de catálogos remotos.DataJson acepta un parámetro validator_class que corre validaciones sobre el catálogo.remove_organizations_from_ckan().push_dataset_to_ckan() para regenerar accessURL de recursos.restore_catalog_to_ckan() pasan a ser de restore_organization. restore_catalog se compone de varias llamadas a restore_organization.restore_catalog_to_ckan.backup.make_catalogs_backup() con argumentos opcionales para facilitar la generación de backups descargando las distribuciones.datasets_frecuencias_cant.None en los indicadores.pydatajson validation http://datos.gob.ar/data.json.distribution_has_time_index para capturar excepciones en field inválidos.distribuciones_federadas, datasets_licencias_cant y distribuciones_tipos_cant.harvest_catalog_to_ckan devuelve el mensaje en lugar de las representaciones de las excepciones.type en distribuciones.pydatajson.harvest_catalog_to_ckan(), devuelve adicionalmente los datasets con errores de federación.setup.py para definir los environment markers de manera que soporte setuptools.harvest_catalog_to_ckan() atrapa todas las excepciones de un dataset y no detiene la ejecución.pydatajson module_name arg1 arg2 arg3 siempre que defina un método main() a nivel del módulo que procese los parámetros.get_distribution_time_index() que devuelve el title del field marcado como time_index en una distribución de series de tiempo, si este lo tiene.harvest_catalog_ot_ckan para manejar excepciones de validación de los datasetspush_dataset_to_ckan()remove_dataset_to_ckan()push_dataset_to_ckan() sea un método que transforma opcionalmente la metadata de un datasetdatasets_equal() permite especificar los campos a tener en cuenta para la comparación, como un parámetro.push_dataset_to_ckan().get_theme() para devolver un tema de la taxonomía específica del catálogo según su id o label.get_time_series()) y un parámetro only_time_series=True or False para filtrar datasets y distribuciones en sus métodos de búsqueda (get_datasets(only_time_series=True) devuelve sólo aquellos datasets que tengan alguna serie de tiempo).get_datasets() y get_distributions(). Tienen un parámetro only_time_series que devuelve sólo aquellos que tengan o sean distribuciones con series de tiempo.helpers.title_to_name()field en un catálogo.superTheme sólo contenga ids en mayúsculas o minúsculas de alguno de los 13 temas de la taxonomía temática de datos.gob.ar.field_title.themeTaxonomy.Cobertura temporal a temporal.DataJson.validate_catalog() y DataJson.generate_datasets_report() tienen nuevas opciones para mejorar los reportes, especialmente en excel.temporalDataJson.validate_catalog():

only_errors=Truefmt="list"core el método DataJson.generate_catalogs_indicators, que genera indicadores de monitoreo de catálogos, recopilando información sobre, entre otras cosas, su validez, actualidad y formato de sus contenidos.pydatajson/schemas/accrualPeriodicity.json).pydatajson sea deployable en nuevos entornos donde el setup.py estaba fallando.Se agrega una nueva función a readers, read_ckan_catalog, que traduce los metadatos que disponibiliza la Action API v3 de CKAN al estándar data.json. Esta función no está integrada a read_catalog.

Se modifican todos los esquemas de validación, de modo que los campos opcionales de cualquier tipo y nivel acepten strings vacías.

Se reestructura la librería en 4 módulos: core, readers, writers y helpers. Toda la funcionalidad se mantiene intacta, pero algunas funciones muy utilizadas cambian de módulo. En particular, pydatajson.pydatajson.read_catalog es ahora pydatajson.readers.read_catalog, y pydatajson.xlsx_to_json.write_json_catalog es ahora pydatajson.writers.write_json_catalog (o pydatajson.writers.write_json).

Se agrega el parámetro frequency a pydatajson.DataJson.generate_harvester_config, que controla la frecuencia de cosecha que se pretende de los datasets a incluir en el archivo de configuración. Por omisión, se usa 'R/P1D' (diariamente) para todos los datasets.

Se agrega la carpeta samples/, con dos rutinas de transformación y reporte sobre catálogos de metadatos en formato XLSX.

xlsx_to_json, con dos métodos para lectura de archivos locales o remotos, sean JSON genéricos (xlsx_to_json.read_json()) o metadatos de catálogos en formato XLSX (read_local_xlsx_catalog()).pydatajson.read_catalog() que interpreta todos las representaciones externas o internas de catálogos conocidas, y devuelve un diccionario con sus metadatos.DataJson.generate_harvestable_catalogs(), que filtra los datasets no deseados de un conjunto de catálogos.harvest a los métodos DataJson.generate_harvestable_catalogs(), DataJson.generate_datasets_report() y DataJson.generate_harvester_config(), para controlar el criterio de elección de los datasets a cosechar.export_path a los métodos DataJson.generate_harvestable_catalogs(), DataJson.generate_datasets_report() y DataJson.generate_harvester_config(), para controlar la exportación de sus resultados.DataJson.generate_datasets_report(), que reporta sobre los datasets y la calidad de calidad de metadatos de un conjunto de catálogos.DataJson.generate_harvester_config(), que crea archivos de configuración para el Harvester a partir de los reportes de generate_datasets_report().DataJson.validate_catalog() se le incorpora una lista ("errors") con información de los errores encontrados durante la validación en cada nivel de jerarquía ("catalog" y cada elemento de "dataset")DataJson.is_valid_catalog() y DataJson.validate_catalog() ahora aceptan un dict además de un path/to/data.json o una url a un data.json.Primera versión para uso productivo del paquete.

pip install debería reconocer correctamente la ubicación de los validadores por default.urlparse.urlparsevalidate_catalog se adecúa a la última especificación (ver samples/validate_catalog_returns.json.FAQs

Paquete en python con herramientas para generar y validar metadatos de catálogos de datos en formato data.json.

We found that pydatajson demonstrated a healthy version release cadence and project activity because the last version was released less than a year ago. It has 2 open source maintainers collaborating on the project.

Did you know?

Socket for GitHub automatically highlights issues in each pull request and monitors the health of all your open source dependencies. Discover the contents of your packages and block harmful activity before you install or update your dependencies.

Product

Socket Firewall Enterprise is now available with flexible deployment, configurable policies, and expanded language support.

Security News

Open source dashboard CNAPulse tracks CVE Numbering Authorities’ publishing activity, highlighting trends and transparency across the CVE ecosystem.

Product

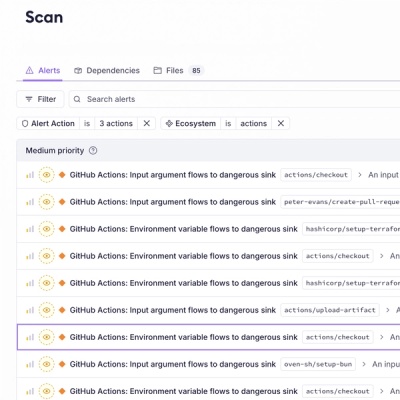

Detect malware, unsafe data flows, and license issues in GitHub Actions with Socket’s new workflow scanning support.