Security News

Research

Data Theft Repackaged: A Case Study in Malicious Wrapper Packages on npm

The Socket Research Team breaks down a malicious wrapper package that uses obfuscation to harvest credentials and exfiltrate sensitive data.

In deze package staan functies die door het datateam MOSS+ van de gemeente Amsterdam gebruikt worden in de data pipelines. Aangezien dit datateam 4 directies bedient, zijn er dezelfde functies die voor verschillende projecten gebruikt worden. Om te zorgen dat er geen wildgroei ontstaat van losse functies of verschillende versies van dezelfde functies is er gekozen om een package te maken die geïmporteerd kan worden.

Deze repo zit in de Proof of Concept fase

Binnen het cluster Digitalisering, Innovatie en Informatie (DII) zit verschillende directies; waaronder de directie Data. Binnen de directie data is er in besloten om het datalandschap te moderniseren. Hiervoor is er gekozen om over te stappen naar Databricks. De functies die jij aanroept via deze packages zijn gemaakt/getest op de Azure Databricks omgeving. Andere omgevingen of andere, niet hieronder genoemde, clusterconfiguraties worden (nog) niet gesupport.

| Cluster Configuratie nr | Access mode | Node | Databricks Runtime version | Worker type | Min Workers | Max Workers | Driver type |

|---|---|---|---|---|---|---|---|

| cluster_configuratie_1 | Single User | Multi | Runtime: 13.3 LTS (Scala 2.12, Spark 3.4.1) | Standard_DS3_v2 (14gb Memory, 4 Cores) | 2 | 8 | Standard_DS3_v2 (14GB Memory, 4 Cores) |

| cluster_configuratie_2 | Single User | Single | Runtime: 14.2 (includes Apache Spark 3.5.0, Scala 2.12) | Standard_DS3_v2 (14gb Memory, 4 Cores) | 1 | 1 | Standard_DS3_v2 (14GB Memory, 4 Cores) |

Op dit moment zijn er verschillende functies beschikbaar.

get_catalog()

clean_colum_names(df.columns) # schoont kolomnamen op

clean_dataframe(df: DataFrame) # schoont een dataframe op

del_meerdere_tabellen_catalog(catalog: str, schema: str, tabellen_filter: str, uitsluiten_tabellen:str = None) # verwijder meerdere tabellen uit de catalogus.

rename_multiple_columns(df, {'oude_naam': 'nieuwe_naam', 'oude_naam_2': 'nieuwe_naam_2'}) # deze hernoemt meerdere kolommen

check_nrow_tabel_vs_distinct_id(tabelnaam: str, id: str) # Controleert of het aantal rijen overeenkomt met het aantal unieke ID's in de opgegeven kolom.

controle_unieke_waarden_kolom(df: DataFrame, kolom: str) #Controleert of alle waarden in een specifieke kolom uniek zijn in het gegeven DataFrame.

convert_datetime_format(input_format): # Converteert het opmaakoptie voor datum en tijd van het datetime (format) naar het PySpark format.

tijdzone_amsterdam(tijdformaat="%Y-%m-%d %H:%M:%S", date_string_timestamp="timestamp"): #Haalt de huidige tijd op en converteert deze naar het opgegeven tijdsformaat en de tijdzone van Amsterdam.

bepaal_kolom_volgorde(df: DataFrame, gewenste_kolom_volgorde: list) -> DataFrame: #Bepaalt de volgorde van kolommen in een DataFrame op basis van de opgegeven gewenste volgorde.

voeg_willekeurig_toe_en_hash_toe(df: DataFrame, business_key: str, naam_id: str) # Neemt de naam van een kolom als invoer aan, veronderstelt dat het een gehashte waarde bevat,

voegt aan elke waarde een willekeurig woord of getal toe en maakt een nieuwe hash..

maak_onbekende_dimensie(df, naam_bk, naam_id="", uitzonderings_kolommen=[]) # Maakt een nieuwe DataFrame met een record voor ontbrekende waarden in een dimensietabel.

vul_lege_cellen_in(df: DataFrame, uitzonderings_kolommen: list = []) #Vult lege cellen in een DataFrame in met standaardwaarden, behalve voor de opgegeven uitzonderingskolommen.

dataset = Dataset(

catalog='catalog_name', # bijv. 'dpms_dev'

database='schema_name', # bijv. 'silver'

project_prefixes=['prefix_'], # bijv. 'sport_'

exclude=['test']

)

dataset.print_eraser_code()

dataset.print_drawio_code()

Deze code omvat reversed modeling; het geeft de input voor tools voor visuele logische modellen op basis van bestaande tabellen en kolomnamen in Databricks.

Deze code geeft in tekstvorm de input van een visueel logisch model in Eraser.io of DrawIO. Dit maakt reversed modeling mogelijk: eerst worden tabellen in Databricks gemaakt, daarna leidt deze code het model daaruit af. Dit maakt het modelleerproces efficienter.

De code kijkt binnen een catalog (bv. 'dpms_dev') en binnen een database (bv 'silver') en dan weer binnen een door de eindgebruiker gedefinieerde naam voor een project (bv 'amis' in de tabelnaam) naar een set tabellen en kolomnamen. Dit resulteert in de volgende metadata:

Deze tools worden momenteel ondersteund (dit kan in de toekomst nog uitbreiden):

Deze features staan op de backlog:

FAQs

Functions needed for datateam MOSS (municipality of Amsterdam)

We found that datateam-moss demonstrated a healthy version release cadence and project activity because the last version was released less than a year ago. It has 1 open source maintainer collaborating on the project.

Did you know?

Socket for GitHub automatically highlights issues in each pull request and monitors the health of all your open source dependencies. Discover the contents of your packages and block harmful activity before you install or update your dependencies.

Security News

Research

The Socket Research Team breaks down a malicious wrapper package that uses obfuscation to harvest credentials and exfiltrate sensitive data.

Research

Security News

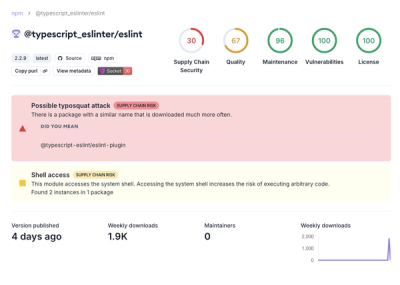

Attackers used a malicious npm package typosquatting a popular ESLint plugin to steal sensitive data, execute commands, and exploit developer systems.

Security News

The Ultralytics' PyPI Package was compromised four times in one weekend through GitHub Actions cache poisoning and failure to rotate previously compromised API tokens.